Moderación de contenido, aplicación práctica de funciones Hash

Carlos Haroldo Mejía Díaz

Knives50215@gmail.com

Estudiante de Ingeniería en Ciencias y Sistemas - USAC

Las plataformas sociales reciben demasiado contenido a diario, y no es de extrañarse que dentro de tanto contenido se encuentren algunos que no cumplan con los términos y condiciones de estas plataformas. Este contenido aparece de manera pública para que otros la puedan ver. Al tener volúmenes tan masivos, surge la pregunta ¿cómo se controla que el contenido sea legal?

Facebook tiene aproximadamente 147,000 imágenes publicadas cada 60 segundos1. Para la moderación de las imágenes la solución tradicional ha sido la subcontratación.

Imagen 1 - Fuente: PBS independant lens

Existen servicios de monitoreo de imágenes, los cuales mantienen equipos de trabajo que se dedican a filtrar el contenido que ha sido subido a la plataforma en caso de que sea marcado como inapropiado por algún usuario. La mayoría de estos servicios están situados en diferentes partes del mundo, capacitando personal respecto a las políticas de las plataformas que monitorean para que sepan exactamente como clasificar el contenido como inapropiado o legítimo. “The Cleaners”2 es un documental realizado en 2018, el cual muestra el proceso que siguen estas instituciones de moderación de contenido. El documental nos muestra las consecuencias que conlleva la censura de contenido, tanto como para los usuarios como para los moderadores.

El factor humano juega un papel importante en este proceso, la clasificación de imágenes con fines artísticos puede a veces confundirse con contenido explicito, sobrepasando los límites de los términos y condiciones de contenido publicable. El documental hace referencia a este tipo de casos y como es que se resuelven a través del entrenamiento y el criterio de los moderadores.

Una de las desventajas que tiene esta solución es la carga psicológica que tienen esta tarea hacia las personas involucradas. Por Seguridad el personal encargado de la moderación accede a firmar un contrato de confidencialidad. No tienen permitido compartir o discutir con nadie el contenido de lo que han clasificado, incluyendo familiares, amigos o el utilizar servicios psicológicos.

Estas personas revisan contenido que varía desde imágenes ofensivas hasta transmisiones en directo de suicidios o auto mutilación. Cada moderador tiene un sistema de creencias y este contenido impacta en su moralidad. Aunque el contenido sea para ellos moralmente inapropiado, si cumple con las regulaciones, este debe de ser marcado como seguro.

En el documental se comparten diferentes perspectivas sobre el contenido que los moderadores manejan día a día. Algunos ven la posición como un deber en el cual ellos se sacrifican para que los demás no tengan que ver este contenido. Otros han aceptado que es un trabajo como todos los demás. Se comenta también de como la carga es tal que uno de los empleados decidió tomar su propia vida, ya que no pudo soportar el estrés y el impacto del trabajo.

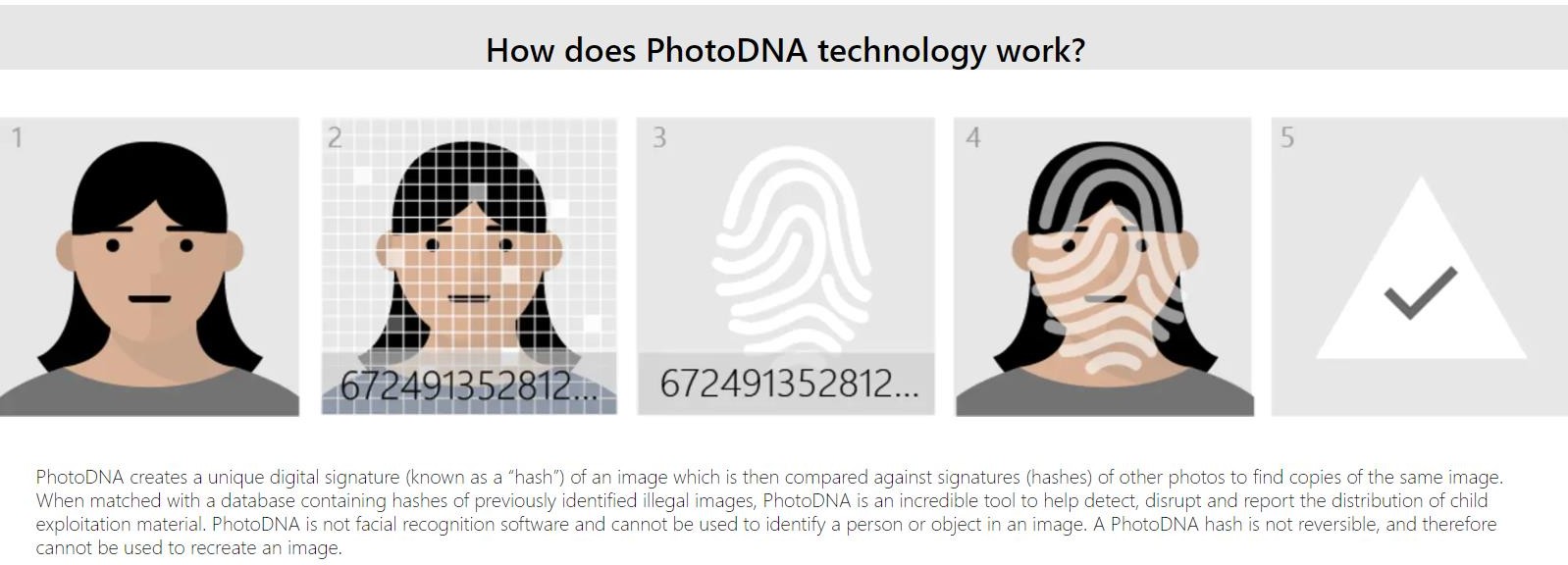

Afortunadamente podemos utilizar nuevas herramientas para reducir el factor humano en estas tareas, pudiendo evitar que más personas estén involucradas en la filtración de contenido. Los desarrollos en inteligencia artificial permiten hacer más fácil la identificación de objetos por medio de entrenamiento de redes neuronales, pudiendo aplicar estas técnicas para la clasificación de contenido ilegal o inapropiado. Dentro de estas herramientas existe PhotoDNA. Esta es una herramienta creada por Microsoft que ha donado a el centro nacional de niños desaparecidos y abuso de menores (National Center for Missing & Exploited Children). Actualmente esta tecnología es usada por el buscador de Microsoft Bing, su sistema de almacenamiento OneDrive, Gmail, Twitter, Facebook y Adobe Systems.

Microsoft dono esta tecnología hacia el proyecto VIC, el cual es soportado y administrado por el el Centro Nacional para Niños Perdidos y Explotados (NCMEC, por sus siglas en inglés). Esta tecnología usa las funciones hash para identificar de manera única imágenes de la base de datos que el FBI proporciona sobre pornografía infantil, y sobre estos hashes se hace la comparación con el contenido subido a las plataformas. De haber encontrado una coincidencia, se alerta a las autoridades correspondientes para que se tomen las medidas de seguridad establecidas.

Pero, ¿cómo funciona esta tecnología? Primero debemos entender que es una función Hash. Esta son funciones las cuales toman un valor de entrada y lo operan mediante diferentes operaciones matemáticas para obtener un valor específico para la entrada. Estas funciones deben de seguir diferentes propiedades, por ejemplo:

Estas deben de tomar una entrada y producir un valor el cual siempre será el mismo para el valor de entrada

Debe de ser lo suficientemente compleja como para evitar llegar al valor de entrada por medio del valor obtenido

También se debe de evitar colisiones, es decir, si un valor de entrada obtiene un valor con esta función, no debe de existir otra entrada que también obtenga el mismo valor

Imagen 2 - Fuente: Microsoft, PhotoDNA

Bajo estas características, se realiza un hash para todas las imágenes de la base de datos. Primero se convierte la imagen a escala de blanco y negro, para evitar que el uso de filtros afecte la detección de estas imágenes. Luego se cambia el tamaño de la imagen y se traza una rejilla para identificar sectores de diferente intensidad de gradientes y también de bordes característicos.

PhotoDNA va un paso más adelante haciendo que los patrones que se identifiquen estén basados en biométrica, permitiendo la generación de códigos únicos para cada imagen respecto a la persona involucrada.

Se aplica a esta imagen una función hash. Esta asegura el evitar las colisiones de 1 en diez billones. En el caso de que el material sean videos, el proceso se ejecuta para cada cuadro del video y se almacena un valor por cada uno.

El tener estas imágenes para generar estos códigos hash es ilegal, por lo que PhotoDNA resolvió esta situación pidiéndole a las agencias de justicia que generen los códigos hash ellos mismos. Estos códigos son distribuidos para los que necesiten utilizarlos por motivos de filtrado de contenido.

Debido al uso de biométrica para la generación de estos códigos, es posible el encontrar coincidencias no solo en las imágenes registradas, sino también en imágenes no registradas. Si se encuentra una coincidencia con alguna de las victimas ya identificadas se pude alertar a las autoridades sobre los posibles autores o distribuidores de este material.

Este método ha sido exitoso para las empresas que lo utilizan. En 2013 esta tecnología ayudo a identificar a un usuario del servicio de almacenamiento de Verizon3, el cual cargo a su cuenta imágenes de pornografía infantil sin tener en cuenta que parte de los términos y condiciones de este servicio establecen que la plataforma escanea el contenido cargado para encontrar coincidencias de este tipo y alertar a las autoridades.

Verizon no es la única plataforma con este tipo de tecnologías. Dropbox posee también una herramienta para identificar este tipo de anomalías, sin embargo, no ha sido posible identificar que herramienta estén utilizando. En el artículo “Dropbox Refuses to Explain Its Mysterious Child Porn Detection Software”4, Kate Knibbs trato de hablar con un representante de la compañía para saber más al respecto, sin conseguir una respuesta clara. Ella concluye que la razón es que estén tratando de evitar que los perpetradores utilicen algún tipo de fallo en este sistema para poder seguir cargando contenido ilegal.

Anteriormente se ha establecido que Dropbox utiliza las funciones hash para revisar infracciones de contenido con copyright, utilizando el mismo procedimiento de generación de códigos de identificación únicos para el material registrado5. Este proceso no revisa los materiales personales lo cual lo hace perfecto para respetar la privacidad de los usuarios.

El documental “The moderators”6 trata el mismo tema de monitoreo de contenido, mostrando el proceso de capacitación en el cual los moderadores se someten antes de clasificar contenido. El documental estima que existen aproximadamente más de 150,000 moderadores de contenido, lo cual es el doble del personal en google y casi 9 veces el personal en Facebook. “No puedes ser dependiente de la automatización” dice uno de los moderadores encargados de la capacitación de nuevo personal. “El sistema comete errores. Los humanos son necesarios, de eso estoy seguro.”

“Podemos construir inteligencias artificiales, pero aun necesitas un operador” Explica otro moderador, “Definitivamente necesitas a una persona detrás de la maquina”. Con el desarrollo de tecnologías de detección de contenido ilegal, se espera reducir la carga de este tipo de equipos, restringiendo la exposición hacia ciudadanos ajenos a los departamentos de justicia.

Conclusiones:

La moderación de contenido es necesaria para las plataformas que almacenan contenido proporcionado por los usuarios.

El desarrollo de nuevas tecnologías en inteligencia artificial puede utilizarse para la detección de contenido ilícito.

Las funciones hash pueden utilizarse más allá de su propósito original de almacenamiento de datos hacia aplicaciones de identificación.

Referencias bibliográficas:

How Verizon found child pornography in its cloud. Disponible 10/4/2019 (3)

Dropbox Refuses to Explain Its Mysterious Child Porn Detection Software Disponible 10/4/2019 (4)

How Dropbox Knows When You're Sharing Copyrighted Files. Disponible 10/4/2019 (5)

Imagen 3 - Fuente: Screengrab The moderators, Field of vision